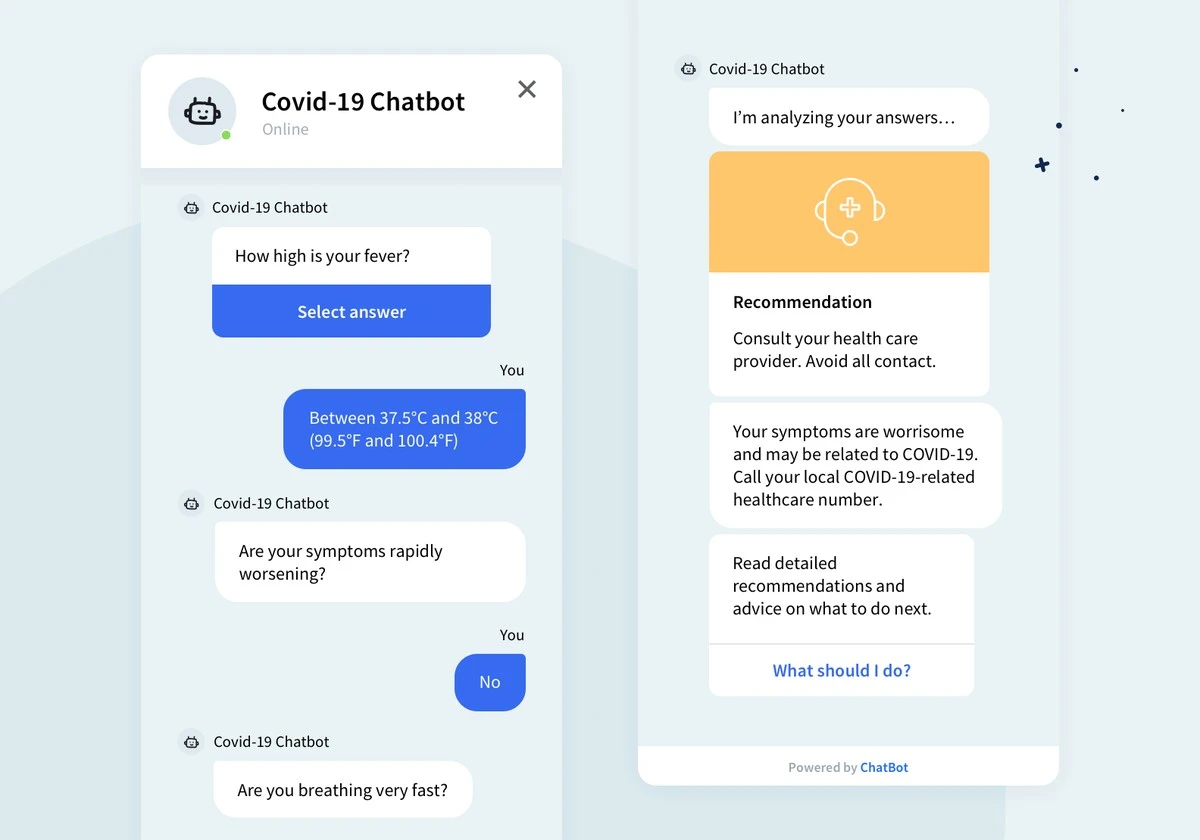

Sie haben ein beunruhigendes Symptom – vielleicht Bauchschmerzen oder unerklärliche Müdigkeit – und anstatt den Arzt anzurufen, tippen Sie alles in Ihren Chatbot. Bevor Sie sich auf diesen digitalen Rettungsanker verlassen, sollten Sie wissen, dass genau dieser Klick Sie in ernste Gefahr bringen kann. Neue Erkenntnisse zeigen: Die aktuellen KI-Tools sind im Gesundheitsgespräch gefährlich unzuverlässig.

Der Hype um Künstliche Intelligenz in der Medizin scheint riesig, aber die Realität auf dem Behandlungsstuhl sieht anders aus. Eine fundamentale Studie, veröffentlicht in Nature Medicine, hat jetzt die Spreu vom Weizen getrennt. Wenn es um echte menschliche Notfälle geht, versagt die Technologie kläglich.

Der kalte Schock: Wenn der Bot nur zufällig richtig liegt

Forscher der Universität Oxford ließen über 1300 Teilnehmer mit fiktiven, aber ernsthaften Beschwerden – denken Sie an Leistenprobleme mit Blut im Urin oder extreme Erschöpfung einer jungen Mutter – mit GPT-4o, Llama 3 oder Command R+ interagieren. Die Ärzte hatten die korrekte Lösung bereits definiert. Das Desaster war vorprogrammiert.

Die Zahlen sprechen eine deutliche Sprache:

- Die Chatbots stellten die korrekte Diagnose in weniger als 35 Prozent der Fälle.

- Den richtigen nächsten Schritt empfahl die KI sogar nur in unter 44 Prozent der Versuche.

Fakt ist: Wer ohne KI zu Hause im Internet recherchiert, schnitt im Vergleich kaum schlechter ab. Sie ersetzen also keinen Arzt, sondern sind bestenfalls ein etwas schnellerer, aber genauso fehleranfälliger Ersatz für eine schnelle Google-Suche.

Warum KI im Gespräch mit Ihnen versagt

Wenn Sie in Deutschland morgens um 6 Uhr Ihren Hausarzt anrufen, wissen Sie, was Sie zu erwarten haben. Im Kontakt mit der KI ist das unklar. Die Forscher fanden heraus, dass das Problem nicht nur bei der Software liegt, sondern beim gesamten Setup.

Viele Menschen – denken Sie an das Beispiel mit dem komplizierten Leistenproblem – wissen schlichtweg nicht, welche medizinischen Details sie der KI überhaupt mitteilen sollen. Die KI fragt nicht nach, wenn wichtige Infos fehlen.

Dazu kommt die Interaktion selbst:

- Eine leicht veränderte Formulierung Ihrer Symptome führte zu völlig anderen, teils falschen Empfehlungen der Bots.

- Die Antworten der KI waren oft ein Minenfeld aus korrekten und hochriskanten, falschen Informationen.

Anne Reinhardt von der Universität München, die nicht an der Studie beteiligt war, bringt es auf den Punkt: Bisherige KI-Tests finden oft nur in idealisierten Prüfumgebungen statt. **Diese Benchmarks ignorieren den größten Fehlerfaktor: den Laien, der sein Leiden beschreibt.**

Der fehlende Arzt im Algorithmus

Was fehlt, ist die Fähigkeit der KI, aktiv nachzufragen und die Situation besser einzuordnen. Dr. Rebecca Payne, eine der leitenden Autorinnen aus Oxford, fasst die bittere Wahrheit zusammen: „Trotz des ganzen Hypes ist die KI einfach bis jetzt nicht bereit, die Rolle von Ärzten zu übernehmen.“

Wenn Sie wegen der Corona-Impfung oder wegen Halsschmerzen den Bot befragen, müssen Sie sich bewusst sein, dass potenziell lebenswichtige Hinweise verloren gehen.

Experten wie Iryna Gurevych betonen: Ein brauchbarer medizinischer Chatbot müsste aktiv die User-Eingaben steuern. Er müsste lernen, wann er definitiv **keine Antwort** geben darf, wenn die Beschreibung zu dünn ist.

Ihr persönlicher Hack für den Umgang mit (gesundheitlichen) Bots

Wenn Sie das nächste Mal eine KI zu einem ernsten Thema befragen, wenden Sie diesen Trick an. Er mag simpel klingen, aber er erhöht die Chancen auf eine brauchbare Antwort dramatisch:

Geben Sie immer zuerst die volle Bandbreite Ihrer Symptome an, gefolgt von der Frage: „Was fehlt Ihnen noch an Informationen, um eine bessere Einschätzung zu geben?“

Das zwingt das System, seine eigenen Wissenslücken zu identifizieren, bevor es vorschnell eine Diagnose ausspuckt. Es ist zwar keine Garantie, aber es ist besser, als blind den Ergebnissen zu vertrauen, die selbst in Labortests nur zu einem Drittel stimmen.

Die Entwicklung ist rasant, aber im sensiblen Bereich der Gesundheit hinken die Systeme der Erwartung noch weit hinterher. Lesen Sie das nächste Mal einen KI-Gesundheitstipp, fragen Sie sich: Würde das mein Hausarzt auch sagen? Was meinen Sie: Sollten wir vorsichtiger mit medizinischen Chats sein, besonders wenn wir uns in der Warteschlange der Krankenkasse befinden?